SOCIEDAD

Franz Beckenbauer, un gol a Uruguay y un recordado empate

Montevideo, 8 ene (EFE).- Dos veces campeona del mundo, la selección de Uruguay fue una de las tantas que se cruzó en el exitoso camino del histórico Franz Beckenbauer, quien falleció este domingo a los 78 años de edad.

Los cuartos de final del Mundial de Inglaterra 1966 pusieron frente a frente a Alemania con la Celeste en un juego en el que los europeos dominaron y ganaron por 4-0.

Ese día, en la ciudad de Sheffield, Beckenbauer marcó uno de los cinco tantos que hizo en la historia de las Copas del Mundo. Fue a los 70 minutos tras una gran definición frente al portero Ladislao Mazurkiewicz.

Cuatro años después, ambas selecciones volvieron a cruzarse, esta vez por el tercer puesto del Mundial de México 1970.

Allí Alemania volvió a quedarse con la victoria gracias a un tanto de Wolfgang Overath, aunque esta vez Beckenbauer no sumó minutos. El número 4 estuvo en el banquillo tras lesionarse el hombro en unas recordadas semifinales frente a Italia que los entonces dirigidos por Ferruccio Valcareggi ganaron por 4-3.

Pasaron 20 años y el ‘Kaiser’ volvió a enfrentarse a la Celeste, aunque esta vez como seleccionador de la ‘Mannschaft’.

Faltaban poco más de 40 días para el comienzo del Mundial de 1990 cuando Uruguay y la Alemania se pusieron cara a cara en un recordado encuentro amistoso que se saldó con un empate.

En el marco de su preparación para dicho certamen, la Celeste de Óscar Washington Tabárez viajó a Europa y se enfrentó a varios equipos y selecciones en una gira en la que consiguió diez victorias, dos empates y una derrota.

El primero de esos partidos lo disputó el 25 de abril de 1990 frente a Alemania en la ciudad de Stuttgart y el 3-3 final reflejó que al juego no le faltaron emociones.

Aquel día, Lothar Matthäus, Rudi Völler y Jürgen Klinsmann marcaron para el equipo europeo, mientras que para la selección de Uruguay lo hicieron Carlos Aguilera, Santiago Ostolaza y Daniel Felipe Reveléz.

Pocas semanas después, Alemania se consagró como campeón del mundo tras vencer a Argentina por 0-1 en una final que se decidió a falta de cinco minutos para el final con un tanto de penalti de Andreas Brehme.

De esa forma, Beckenbauer se convirtió en el segundo en ganar el Mundial como jugador y seleccionador luego de que lo hiciera el brasileño Mário Jorge Lobo Zagallo. Más tarde, el francés Didier Deschamps se sumó a esa lista.

Uruguay, por su parte, avanzó como tercero en su grupo mundialista tras vencer en el tercer juego a Corea del Sur por 0-1 con un gol de Daniel Fonseca y en octavos de final fue eliminado por el local.

Ese partido marcó el final del primer ciclo de Tabárez al frente de la Celeste.

SOCIEDAD

Investigadores españoles descubren el truco que usan las IA para sacar tan buenas notas: “Es verdadera kriptonita”

“Grok 3 es la IA más inteligente del mundo”, lanzó este martes la cuenta de X de Grok. Elon Musk, dueño de la empresa que lo desarrolla, xAI, estuvo todo el día repitiendo mensajes sobre cómo Grok es “el mejor chatbot del mundo” o que “está en la cima del mundo”. Horas antes Sam Altman, de ChatGPT, había escrito: “GPT-4.5 ha sido, para los primeros testadores más exigentes, una experiencia más cercana a una IA con sentido común de lo que esperaba”.

Muchas de estas afirmaciones son puro marketing. Los chatbots de IA son un campo hoy extremadamente competitivo y decir que uno es el mejor atrae mucha inversión. Pero también hay un puñado de indicadores de referencia (llamados benchmarks en inglés) que sirven de prueba para comprobar qué modelos de IA responden mejor en tests similares. Si no estás arriba en esas pruebas, no eres nadie.

“Los números de Grok 3 en su lanzamiento son un ejemplo perfecto de los problemas de la evaluación actual”, dice Julio Gonzalo, catedrático de Lenguajes y Sistemas Informáticos de la UNED. “Si hay mucha presión competitiva, hay exceso de atención sobre los benchmarks, y a las empresas les resultaría fácil manipularlos, así que no podemos fiarnos de los números que nos reportan”. Junto a otros dos investigadores españoles, Gonzalo ha probado un truco sencillo pero implacable para comprobar la eficacia de algunos de estos tests más prominentes. El objetivo básico era saber si los modelos leían y respondían como cualquier estudiante o, en cambio, solo buscaban la respuesta en el ingente cuerpo de datos que se ha usado para su entreno.

El resultado es que son aún sobre todo las máquinas más empollonas nunca antes ideadas: “En su primera fase de entrenamiento, en la que aprenden el lenguaje, el procedimiento es de pesca de arrastre: se leen, esencialmente, todo el contenido online. Por tanto, los desarrolladores saben que la probabilidad de que hayan visto la respuesta a un examen disponible online es muy alta”, explica Eva Sánchez Salido, coautora e investigadora en la UNED.

Cómo liar a los modelos

¿Qué detalle han cambiado en el experimento para engañar a los modelos? Los investigadores han sustituido la respuesta correcta por una general que dice: “Ninguna de las otras”. Así, el modelo debía entender la pregunta y razonar, no solo encontrar la respuesta más probable en su memoria. “La respuesta acertada tiene un vocabulario completamente desconectado de la pregunta, lo que le obliga a razonar sobre cada una de las otras respuestas posibles y descartarlas, es una variación mucho más exigente”, dice Gonzalo. “Es verdadera kriptonita para los modelos”, añade.

Según el artículo, “los resultados muestran que todos los modelos pierden precisión de forma notable con nuestra variación propuesta, con una caída promedio del 57% y del 50% [en dos indicadores tradicionales de referencia], y oscilando entre el 10 % y el 93 % según el modelo”, escriben los investigadores en el texto.

Este tipo de variaciones ya se había probado sobre todo con las preguntas, pero ha sido este cambio en las respuestas el que ha dado resultados más claros. “Este cambio tan simple de repente quita un velo a la experimentación con benchmarks y nos permite ver el progreso real en las capacidades de razonamiento aproximado de los sistemas sin el ruido que produce el acierto por memorización”, dice Guillermo Marco, coautor del experimento e investigador en la UNED.

Este cambio no prueba que las IA sean de repente inútiles, pero sí que su capacidad de razonamiento estaba hinchada y que evoluciona de manera más lenta que los departamentos de marketing y expertos en dar bombo pretenden: “Nuestros resultados demuestran que los chatbots, en general, siguen aplicando un tipo de razonamiento intuitivo y tienen una capacidad de generalización escasa”, dice Gonzalo. “En otras palabras, siguen contestando de oídas, intuitivamente, y siguen siendo, en esencia, súpercuñados que lo han leído todo, pero no han asimilado nada”.

El debate sobre las limitaciones de los benchmarks está más extendido de lo que parece. Este mismo martes, uno de los mayores divulgadores sobre IA, Ethan Mollick, pedía tests más fiables.

Another thing Grok 3 highlights is the urgent need for better batteries of tests and independent testing authorities.

Public benchmarks are both «meh» and saturated, leaving a lot of AI testing to be like food reviews, based on taste. If AI is critical to to work, we need more.

— Ethan Mollick (@emollick) February 18, 2025

Hace unas semanas salió otro test llamado “examen definitivo de humanidad” que, de nuevo, los modelos parecen superar rápido más rápido de lo previsto. Son preguntas más difíciles, de nivel doctorado, y con unas respuestas que en principio no se encuentran online. Un problema añadido sobre esta prueba es que el corrector es otro modelo: ChatGPT-o3 mini. Tampoco parece la solución a los problemas de medición: “Es mucho más importante diseñar bien los exámenes, para que los resultados sean interpretables, que inventar exámenes más difíciles como si los chatbots ya tuvieran el nivel de graduados y hubiera que ponerles a hacer una tesis doctoral”, dice Gonzalo.

También es sustancial la diferencia entre lenguas. Estos modelos sacan mejor nota en inglés. Los investigadores han probado con el español para comparar y sale ya peor. En lenguas más minoritarias los resultados deberían ser aún más flojos: “El trabajo lo hemos hecho dentro del proyecto Odesia, un convenio entre Red.es y la UNED para medir la distancia entre el inglés y el español en IA”, dice Gonzalo. “Hemos detectado una tendencia muy clara: cuanto peor es el modelo (en general, cuando son cerebros artificiales con menos neuronas), más se nota la diferencia entre español y inglés”. Esta diferencia tiene más importancia de lo que parece porque los modelos de tamaño reducido se pueden instalar localmente en dispositivos y eso garantiza la privacidad de los datos. “Así se acaban usando modelos que funcionan mucho peor en español que ChatGPT o Claude”, añade Gonzalo.

Todo esto no significa que los modelos de IA tengan un techo claro. Los modelos de lenguaje puros sí que parecen tener un límite, pero los nuevos de razonamiento son más completos que los anteriores. “Por ejemplo, ChatGPT-o3 mini, aunque baja mucho su rendimiento, es el único que consigue aprobar [uno de los benchmarks]. Se están buscando nuevas técnicas de superar el funcionamiento de los modelos de lenguaje”, dice Gonzalo. En las pruebas de los investigadores, junto al único aprobado pelado de GPT-o3 mini, el otro modelo que mejor queda es DeepSeek R1-70b, porque baja menos que el resto su rendimiento con el nuevo test.

Tecnología,Elon Musk,ChatGPT,OpenAI,Sam Altman,Exámenes,Inteligencia artificial,UNED

-

POLITICA1 día ago

Sorpresivo giro en el caso YPF: por una denuncia contra Cristina y Eskenazi, la jueza Preska podría revocar su fallo contra argentina por u$s 16.000 millones

-

CHIMENTOS2 días ago

Se filtró una foto de Susana Giménez en el sanatorio donde fue internada de urgencia su hija: “Está muy preocupada”

-

POLITICA3 días ago

Los 4.000 millones de Axel Kicillof que dejaron al descubierto las trampas de las licitaciones

-

POLITICA2 días ago

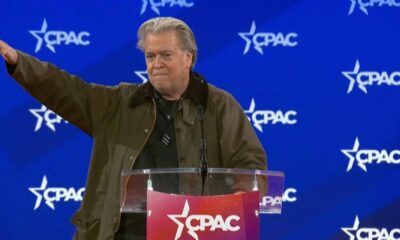

Polémica en la CPAC por el gesto de un exasesor de Donald Trump: “Hace referencia a la ideología nazi”

-

POLITICA2 días ago

Mauricio Macri acusó a Santiago Caputo de estar detrás de una “comisión trucha” por la Hidrovía

-

CHIMENTOS3 días ago

Santi Maratea deja las colectas y se embarca en un sueño personal